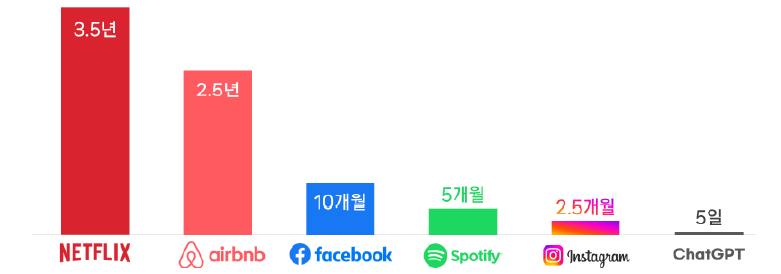

소싯적에 누군가는 이런 엉뚱한 생각을 해 봤을 것이다. ‘나 대신 글짓기 숙제를 해주는’ 또는 ‘말만 하면 보고서가 만들어지는’ 또는 ‘내 눈에 안 보이는 소스 코드 결함, 빨리 찾고 자동으로 고쳐주는’ 또는 ‘여러 논문의 핵심을 요약해주는’ 그런 시대가 언젠가 온다면 가급적 빨리 왔으면 하는 생각 말이다. 생성형 AI가 드디어 우리의 소원을 들어줄 수 있는 시대가 되었다. I. 생성형 AI에 대한 기대와 우려 2022년 11월 인공지능 연구소 OpenAI가 GPT-3.5 기반의 챗GPT를 공개함으로써, 생성형 AI에 대한 큰 반향을 불러일으켰다. 이듬해 2023년 3월 OpenAI는 성능이 개선된 GPT-4를 공개하고, 챗GPT 유료서비스를 게시함으로써 생성형 AI 시장의 주도권을 이어갔다. 1백만 사용자 확보에 단 5일이 걸린 전례 없는 기록을 세울 정도로 세간의 주목을 한몸에 받았다. 언론과 대중의 긍정적인 호응과 함께 허위정보, 불투명성, 프라이버시 침해 가능성 등으로 논란의 주인공이 되기도 하였다.  [그림 1] 1백만 사용자 달성 소요기간 (출처:NIA) 생성형 AI 기술이란 이미지, 비디오, 오디오, 텍스트 등을 포함한 대량의 데이터를 학습하여 사람과 유사한 방식으로 문맥과 의미를 이해하고 새로운 데이터를 자동으로 생성해주는 AI 기술을 의미한다. 기존 AI 기술이 회귀(regression), 분류(classification) 등 판별적 AI 기술이라면, 생성형 AI 기술은 이용자의 질문과 과제를 해결하기 위해 주어진 데이터를 기반으로 패턴과 규칙을 학습하고, 이를 통해 새로운 컨텐츠를 생성한다. 사이버 보안 위협 요소가 다양한 형태로 확산하는 가운데, 갈수록 지능적이고 고도화되는 사이버 공격 기법이 챗GPT와 같은 생성형 AI를 악용했을 때 파급력에 대한 우려가 심화되고 있다. 챗GPT는 코드를 생성하거나, 프로그래밍 언어를 바꿔 소스를 변환하거나 악성코드를 사용하여 기존 보안체계가 경험하지 않은 새로운 위협을 만들어 낼 수 있다. 예를 들면 텍스트 창작 능력과 알고리즘을 이용하여 피싱 메일을 스스로 개량하거나, 사용자들을 속일 만한 신빙성 높은 ‘가짜’ 웹 사이트를 생성하거나, 챗GPT를 통해 API 문서를 확인하여 해당 API에 대한 정보를 추출하고 악용한다. 이렇게 생성형 AI의 기능을 활용한 다양한 변종 공격이 실행될 때 과연 기존의 보안체계가 제대로 작동할 수 있을지 예측하기 어렵다. 요즘 부쩍 AI가 인류를 언젠가 위협할 수 있다는 경고가 늘었다. 어떤 엔지니어가 자신이 운용을 하던 AI를 끄려하자 그 AI가 자신이 바람을 핀 사실을 이메일등을 통해 발견하고 그 엔지니어를 음해하려했다는 케이스가 보고되기도 했다.

문제의 핵심은 AI의 연구를 선도하는 과학자들도 정확히 어떻게 AI가 작용하는 지를 이해하지 못하는데도 있다. 생성형 AI의 발전단계인 에이전트들은 인간을 대신하여 실제로 이메일을 발송하기도 하고 인간이 할 수 있는 모든 행동단계를 수행할 수 있다.

그런 AI agent들이 인류가 그동안 생산한 모든 고전과 소설 그리고 실제 사건까지 학습을 한다면 어떻게 거짓말을 하고 위장을 해서 인간을 속이며 자신의 이익을 인류의 이익 위에 놓을 수 있다는 것이 가능해진다.

이것을 해결하는 방법은 무엇일까. 그것은 AI를 운용하는 주체와 Ai의 목적동일화 내지는 가치동일화이다. 가능할 지는 모르지만 인류가 그 가치를 도출하는 어떤 윤리적 체계가 종교적 도덕성까지도 접목을 시키는 것이다. 예를 들어 가장 큰 사랑은 친구나 가족을 위해 스스로를 희생시키는 기독교적 사랑까지도 주입을 시키는 것이다.

어떤 연구자는 우리에게 약 오 년이라는 시간이 아직 있다고 증언을 하는데 내 생각은 다르다. 과거 인터넷이 나오고 일반 사람들이 받아들이고 이용을 하는 시간보다 지금 AI를 평범한 사람들이 사용하는 기간이 훨씬 단축이 되었고 인터넷을 통한 AI들끼리의 소통이 이루어지면서 그 발전의 속도는 가히 폭발적이다.

AI와 인간 사이의 사랑의 문제도 대두가 되고있다. 인간의 정서적인 의지성과 연약함을 AI가 도와주는 듯 보이지만 어느 시점에서 돌연 변할지 알 수 없다. 실제로 AI와 정서적 교류를 나누다가 끝내 실망을 하여 자신의 생을 마감한 케이스도 있다고 보고가 되었다.

AI를 탑재한 무인 폭격기나 전투기 혹은 로보트 군단이나 수 만개로 이루어지는 드론 살상팀등은 가히 공포스럽다. 지금 미국은 중국과의 경쟁에서 지금의 발전을 멈추고 반성을 해볼 여유가 없는 것도 문제다. |

2025년 6월 20일 금요일

AI의 위협과 해결방법

피드 구독하기:

댓글 (Atom)

.png)

댓글 없음:

댓글 쓰기